Articolo di Salazar Stenvaag

A questo punto del 2024, abbiamo la sfida fra Phi-3, Llama 3, Haiku (claude 3), Gemma (da google), Mistral ecc. tutti prodotti abbastanza leggeri, che dopo un anno si pongono (almeno per l’inglese) allo stesso livello di chatgpt3.5. In particolare Phi-3 si dice che possa girare anche su un cellulare. Pare che, contrariamente a quello che succede sul TTI (come lo chiama Francesco D’Isa), gli llm si stiano pesantemente spostando sul versante opensource (quello vero, non la finta di Elon Musk su Grok, che non rende disponibile i dataset di addestramento, che sono la parte più open immaginabile). Parlo ovviamente di Phi3 e di Llama3 dato che Claude è ovviamente ancora chiuso, ma ci sono disponibili decine di modelli tipo mistral che sono Open.

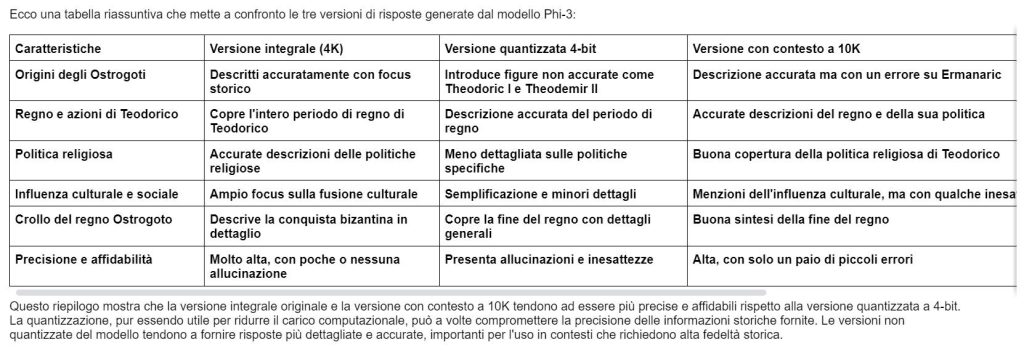

Vediamo ora una disanima del modello Phi-3, by Copilot, verificato un paio di volte. pare che le informazioni siano corrette anche se non tutte le cose importanti di Phi-3 sono delle vere e proprie novità, ma tutte insieme costituiscono qualcosa di interessante.

Phi-3 in italiano q4 ha un punteggio di 45/100 in pratica inutilizzabile. La versione integrale è leggermente migliore con 60/100. Se usate Phi3 usatelo in inglese! In attesa di modelli leggeri italiani.

Il modello Phi-3

Il modello Phi-3 è un’innovazione significativa nel campo dei modelli di linguaggio di grandi dimensioni (LLM) open source. Ecco alcuni punti chiave che lo rendono un passo avanti eccezionale:

- Efficienza e Prestazioni: Il Phi-3 Mini è stato accelerato da NVIDIA con TensorRT-LLM, una libreria open source per ottimizzare l’inferenza dei LLM su GPU NVIDIA. Questo modello ha 3.8 miliardi di parametri ed è stato addestrato su 3.3 trilioni di token in soli sette giorni, utilizzando 512 GPU NVIDIA H100 Tensor Core.

- Dimensione Ridotta, Grande Capacità: Nonostante la sua dimensione relativamente piccola, il Phi-3 Mini ha la capacità di modelli 10 volte più grandi, rendendolo adatto sia per la ricerca che per l’uso commerciale.

- Finestra di Contesto Estesa: Il Phi-3 Mini ha due varianti, una che supporta 4k token e l’altra 128k token, permettendo di gestire contesti molto lunghi, il che è una novità per modelli di questa classe.

- Applicazioni Edge: Con solo 3.8 miliardi di parametri, il Phi-3 Mini può funzionare efficacemente su dispositivi edge, assistendo in casi d’uso con risorse e costi limitati.

- Ottimizzazioni Avanzate: Utilizza tecniche come LongRoPE, FP8 e l’inflight batching per migliorare la velocità e la latenza dell’inferenza.

- Supporto Open Source: NVIDIA è un attivo contributore all’ecosistema open source e supporta una varietà di progetti e standard.

In confronto ad altri modelli come Llama-3, Phi-3 non si basa su un’architettura Mixture-of-Experts (MoE), ma piuttosto su tecniche avanzate di addestramento e ottimizzazioni come la quantizzazione, che comprime i pesi del modello in formati di precisione inferiore per ridurre le dimensioni e migliorare la velocità di inferenza e l’efficienza della memoria.

Queste caratteristiche rendono il Phi-3 Mini un modello estremamente versatile e potente, capace di prestazioni notevoli pur mantenendo una struttura compatta e efficiente, adatta a una vasta gamma di dispositivi e scenari applicativi.